Et voila, un jour après le printemps et un jour avant de se prendre un nuage radioactif sur la tête (ca c’est une private joke pour ceux qui me suivent sur twitter), j’écris cet article qui à la base n’était pas prévu. Pas prévu pourquoi ? Parce que j’ai déjà 3 autres articles à finir. Parce que cette découverte n’est pas une révolution en soi et parce que j’ai déjà échangé avec la personne intéressée sur twitter (@Sventovit) et entre normands on se comprend. Pourquoi l’écris-je alors ce billet ? Parce que j’ai une bouche et il y a des choses qui m’irritent dans la vie, et pour ces choses là, la cetirizine n’y fait malheurseusement pas grand chose.

Comment monte la tension ?

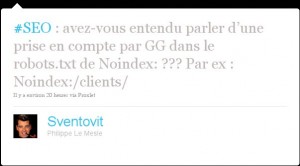

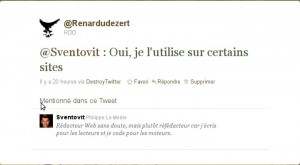

Et bien c’est assez simple. Twitter c’est bien pour la veille, pour échanger et accessoirement pour perdre du temps. Suite à une question de Philippe alias @Sventovit sur la prise en compte par Google de la directive Noindex dans le fichier robots.txt, je lui réponds que oui Google en tiens compte.

Je n’affirme pas ça dans le vent puisque c’est un test que j’ai mis en place en 2008 et qui d’après le GWT et les (non-) résultats dans les SERPs de Google fonctionne toujours. Mais ça nous le verrons par la suite.

Pour tout remettre dans son contexte, voici le sujet :

Alors oui, cette personne a 10 fois plus de followers que moi (ce n’est pas le sujet et perso je m’en br**le), oui je passe pour un Geek (que je ne suis absolument pas) et cerise sur le gâteau, l’annonce que je fait passe pour fausse, d’ou cet article.

Alors cher monsieur que je ne connais pas mais que me fait passer pour un con, voici LES FAITS.

La directive Noindex dans le robots.txt

Je ne suis pas un grand fan du robots.txt comme vous avez surement pu le constater dans l’article Robots.txt, ce qu’il faut eviter. Cependant je suis curieux et plutôt cartesien donc quand je lis quelque chose d’intrigant, surprenant ou paraissant impropable, quand j’ai le temps et les moyens de tester, je le fais.

Remontons donc le temps en Novembre 2007 ou un célèbre sebastian éveille ma curiosité avec son article Q&A: An undocumented robots.txt crawler directive from Google et encore plus avec les résultats de ces tests et une annonce de John Müller Validate your robots.txt – Googlebot becomes smarter.

Je décide donc de mettre cela en place sur quelques sites et de vérifier la véracité de ces propos.

Début 2008 je mets ces quelques sites dans le GWT, et effectivement, cela fonctionne.

Donc pour les sceptiques qui pensent que je balance de l’intox (les screens sont d’aujourd’hui)

Et il en résulte :

Alors oui, comme je le dis dans l’intro de ce billet ce n’est pas une révolution, je lui préfère d’autres méthodes et oui cher monsieur cela fonctionne parfaitement bien avec Google (pour les autres je n’affirme rien puisque je n’ai pas testé).

En conclusion, avant de balancer une remarque de ce genre sur twitter, on se renseigne hein, c’est pas parce que ce n’est pas écrit dans les sacro-saintes Google Guidelines ou ailleurs que ça ne fonctionne pas, ça évitera de faire passer les gens qui ont testé pour des cons. D’ailleurs le nucléaire c’est pas dangereux, ont peu même bouffer de l’uranium et du plutonium, c’est totalement inoffensif pour la santé => Humour #Geek.

Adeptes du content is truth, Salut.

19 réponses sur « Directive Noindex et robots.txt »

Brassens chantait quand on est…

Si tu dois réagir à chaque attaque sur Internet, prévoit de passer le reste de ta vie à écrire des billets. 🙂

Heu… je crois que tu te fourvoies RDD. Tu as sans doute mal pris son twit (qui, on est d’accord, est inutile) et moi-même ai du mal à voir ce que Mr Legay (évitons les blagues geek sur son nom \o/) a bien pu vouloir dire.

Bref, merci de la mise au point mais comme disait Jocelyne Labylle, « laisse parler les gens ».

@Gwa :

Oui oui nous sommes d’accord.

Pour ce billet, ce n’est pas l’aspect attaque qui me gêne, je suis un grand pacifiste dans l’âme, c’est plutôt le fait de véhiculer une fausse information qui m’irrite.

« Si tu dois réagir à chaque attaque sur Internet, prévoit de passer le reste de ta vie à écrire des billets. » => tu as prévu de m’attaquer pour le reste de ma vie 😉

Depuis ton guet-apens au seo campus, je dédie ma vie à ça!

@vendée :

J’espere m’etre fourvoye, mais les brefs echanges que j’ai pu avoir avec lui m’on montre qu’il parlait de chose qu’il ne maitrisais pas (il m’a demande pourquoi garder un robots.txt sur le site dans ce cas la).

Pour laisse parler les gens je suis d’accord, cf ma reponse a @gwaradenn

@Gwaradenn :

Bon heureusement que j’ai passé une partie de ma vie dans les opérations commando, je suis préparé a ce type d’attaque. Entre ça et les menaces nocturnes de Paul, je vais devoir passer en mode Shaolin 😉

Perso moi c’est plus son « Mais dans ce cas pourquoi conserver un fichier ROBOT.TXT sur le site ? » qui me laisse circonspect.

Il y a de nombreux interets a avoir un robots txt pour empecher l’indexation d’un site que ce soit pré-lancement (pour empecher le crawl d’une version non finie du site – ou post lancement (empecher le crawl des images, de certains documents pdf/words/excels etc…)

C’est quand meme quelqu’un qui bosse dans le web…

@Le Juge SEO

Oui en effet, sa deuxième question est encore plus incompréhensible et je lui ai répondu très courtoisement.

Pour en revenir au robots.txt, pour la version en pré-production, il est vraiment indispensable (j’en ai fait les frais récemment d’ailleurs) et comme tu le dis, pour les images et compagnie c’est également valable en (post-)production.

Oui oui, il bosse dans le web !! Si il n’avait pas eu 2692 followers qu’il désinforme de cette manière, j’aurai largement laissé pisser.

« la version en pré-production, il est vraiment indispensable (j’en ai fait les frais récemment d’ailleurs) »

Ah tiens toi aussi – pas plus tard qu’il y a 2 semaines j’ai distribué des rafales des baffes a mes dev parce que je dois me cogner la redirection page a page d’un des sous domaines qu’on utilise en pré production sous-domaine-client.maboite.com qui prenait tous les rankings visé par le client (normal puisque ss-domaine plus vieux) tout ca parce qu’ils ont pas bien fait gaffe a 1 lien tout pourri et qu’ils ont pas mis le sous domaine en Noindex (alors que c’est un process de prod que j’ai imposé en arrivant).

@Le juge SEO:

La micro boulette qui peut faire mal. Une seule porte d’accès pour GGBot et il t’engloutit le sous-domaine en moins de 2 sec.

Pour ma petite histoire, c’est encore plus saugrenu et je suspecte une certaine barre d’un certain moteur de recherche de balancer certaines informations.

Pour faire bref, je balance à mon boss des urls de pre-production quand je suis en télé-travail pour qu’il vérifie avant mise en ligne. Et à ma grande stupeur, je vois apparaître ces pages dans l’index GG quelques jours après (pour info rien dans bing et rien dans Yahoo).

Je check alors immédiatement les logs et la grande surprise, lors du premier crawl de GGBot, pas de referrer => bizarre.

Je voulais d’ailleurs écrire un billet la dessus, mais je dois pousser les tests un peu plus loin pour être sur de cette embuscade. Mais j’affirme que je n’avais rien ni dans Yahoo ni dans Bing, donc je vais creuser cela de plus près (et il ne pouvait pas y avoir de lien vers ce sous-domaine puisque je venais de le créer)…

Donc dorénavant, c’est Disallow:/ d’office sur mes devs en pre-prod.

Hello mon goupil préféré.

Assez surprenant en effet ce tweet de Monsieur Legay et l’échange qui s’en suit sur Twitter.

Je ne comprends pas non plus son propos.

Mais, toi, par contre, je t’ai bien compris et tu m’as rendu service. Merci à toi donc.

Je ne suis qu’un petit jeune (par l’expérience et non par l’âge) dans la création de sites et je ne suis qu’un amateur du dimanche pour le référencement malgré un veille journalière depuis 5 ans. La seule certitude que j’ai, c’est qu’il y a beaucoup de désinformations dans ce milieu et que seuls ces propres tests peuvent valider des dires.

@RDD

Yup, Idem (indexation barre d’outil) – y a des barres d’outils qui sont suspectes mais qu’on peut pas vraiment prouver si elles balancent ou pas. – tiens moi au jus pour ton test

Perso je fait plutôt l’interdiction d’accès à coup de :

Cela évite de laisser dans le robots des informations « sensible » quand on veut juste que certaines pages ne soit pas indexé. J’évite ainsi de mâcher le travail à la concurrence qui n’a plus qu’à lire mon robots.txt. 🙂

Après si c’est pour interdire tout un domaine (sous-domaine) un « Disallow:/ » fonctionne bien et puis pour certains documents comme les PDF on ne peut pas faire autrement.

Comme Arkanys je pense que seul les tests effectués (par soi ou par un tiers de confiance) permettent de valider une hypothèse en SEO.

Merci pour cette réflexion pertinente,

Pierre

noindex n’est pas supporté par Bing et Yahoo (pas testé mais source = SeoMoz & friends).

Christophe

C’est vrai que vu le nombre de followers il y a de quoi être énervé! C’est sur que le meilleur moyen en SEO pour vérifier une info s’est de faire des tests soi même.

Ah je ne connaissais pas cette directive, et les commentaires m’ont permis de comprendre son utilité.

D’ailleurs, pour suivre quelques conseils avisés, je vais tester moi-même.

Merci

Grâce à ce genre d’initiatives beaucoup de gens, dont moi, peuvent du coup parler de leur petite affaire et évoluer au sein de ce monde cruel qu’est le ouèbe 🙂 merci , grâce à vous, j’ai pu passer premier dans un « concours » de référencement avec ma formation, le mot clé est csilesexpertsrennes, donc facile au premiser abord, mais mes concurrents sont féroces, alors merci pour tout, si vous voulez suivre mon histoire ! http://csilesexpertsrennes.jeremy-alluin.fr/ Merci et bonne continuation !!

la meilleure solution c’est de ne pas autoriser robot.txt… pour laisser l’acces a tt le siteweb et bien le referencer

Bon, je suis un peu en retard par rapport à l’article, mais je confirme la même histoire avec la barre d’un « certain moteur de recherche ». Très énervant.

D’autant que si ton projet est un temps soit peu « chaud », mettre un disallow sur un sous.domaine est une vraie indication pour tes concurrents.

Sinon, une question : qu’as-tu constaté comme délai de désindexation après la mise en place d’un disallow ?